Mục lục [Ẩn]

Transformer Model là một trong những đột phá quan trọng nhất trong lĩnh vực trí tuệ nhân tạo hiện đại, đặc biệt trong xử lý ngôn ngữ tự nhiên. Với khả năng hiểu ngữ cảnh sâu và tạo ra nội dung giống con người, Transformer Model đang trở thành nền tảng cho các ứng dụng AI như ChatGPT, Google Translate hay hệ thống phân tích dữ liệu doanh nghiệp. Trong bài viết này, AI FIRST sẽ giúp bạn hiểu rõ Transformer Model là gì, hoạt động ra sao và cách ứng dụng hiệu quả trong kinh doanh.

1. Transformer Model là gì?

Transformer là một mô hình trí tuệ nhân tạo AI được thiết kế để xử lý ngôn ngữ tự nhiên, bằng cách học các quy luật ngữ nghĩa và cú pháp từ khối lượng lớn văn bản. Nhờ cơ chế tự chú ý (self-attention), mô hình này có thể hiểu được mối liên hệ giữa các từ trong câu, từ đó tạo ra nội dung có ngữ cảnh rõ ràng và tự nhiên như con người viết.

Trái ngược với các phương pháp truyền thống như RNN vốn gặp khó khăn khi xử lý chuỗi dài, Transformer cho phép kết nối thông tin xuyên suốt toàn bộ văn bản một cách nhanh chóng và hiệu quả. Đây cũng là nền tảng cho sự ra đời của các mô hình ngôn ngữ lớn (LLMs) hiện đại như GPT, BERT…, góp phần nâng cao năng lực AI trong các lĩnh vực như viết nội dung, phân tích dữ liệu, dịch thuật, và giao tiếp tự động.

2. Các thành phần của Transformer Model

Kiến trúc Transformer được xây dựng từ nhiều lớp và cơ chế chuyên biệt, phối hợp nhịp nhàng để xử lý ngôn ngữ một cách hiệu quả và linh hoạt. Mỗi thành phần đóng vai trò quan trọng trong việc hiểu ngữ nghĩa, xác định ngữ cảnh và tạo đầu ra phù hợp. Dưới đây là các thành phần cốt lõi tạo nên sức mạnh vượt trội của Transformer Model:

2.1. Lớp nhúng đầu vào (Input Embeddings)

Lớp nhúng đầu vào là bước đầu tiên trong kiến trúc Transformer, có chức năng chuyển đổi các từ trong văn bản thành các vector số có ý nghĩa ngữ nghĩa. Mỗi từ hoặc cụm từ được biểu diễn bằng một dãy số đa chiều, giúp mô hình xử lý dữ liệu ngôn ngữ dưới dạng toán học.

Các từ có ngữ nghĩa tương đồng sẽ được ánh xạ gần nhau trong không gian vector, nhờ đó mô hình có thể nhận biết và xử lý những mối quan hệ giữa các từ trong cùng một ngữ cảnh. Điều này đặc biệt quan trọng trong các ứng dụng như phân tích nội dung hợp đồng, phân loại cảm xúc khách hàng, hoặc phân nhóm chủ đề văn bản.

2.2. Mã hóa vị trí (Positional Encoding)

Transformer không sử dụng cấu trúc tuần tự như các mô hình truyền thống, do đó cần một cơ chế để mô hình nhận biết được thứ tự các từ trong chuỗi. Mã hóa vị trí đảm nhận vai trò này bằng cách gán thêm thông tin về vị trí cho từng từ, đảm bảo rằng mô hình hiểu được trật tự ngữ pháp và cấu trúc câu.

Kỹ thuật này giúp Transformer duy trì được ngữ cảnh chính xác khi xử lý văn bản dài, nơi thứ tự từ đóng vai trò quan trọng trong việc xác định nghĩa. Trong các ứng dụng thực tế như phân tích nhật ký giao dịch tài chính hoặc chuỗi hành vi người dùng, mã hóa vị trí giúp mô hình phát hiện các mẫu bất thường dựa trên trình tự hành động.

2.3. Cơ chế tự chú ý (Self-Attention)

Cơ chế tự chú ý là thành phần cốt lõi giúp Transformer hiểu được mối liên hệ giữa các từ trong cùng một câu hoặc đoạn văn bản. Thay vì xử lý từ ngữ một cách rời rạc, mô hình sử dụng self-attention để xác định mức độ ảnh hưởng của các từ đến nhau trong cùng một ngữ cảnh.

Với khả năng này, mô hình có thể tập trung vào những từ khóa quan trọng và bỏ qua các phần không cần thiết, giúp cải thiện độ chính xác trong việc phân tích ngữ nghĩa. Cơ chế tự chú ý được ứng dụng rộng rãi trong chatbot, hệ thống phân tích phản hồi khách hàng, và công cụ hỗ trợ ra quyết định dựa trên văn bản.

2.4. Cơ chế đa đầu chú ý (Multi-Head Attention)

Multi-Head Attention là sự mở rộng của cơ chế tự chú ý, cho phép mô hình phân tích thông tin từ nhiều góc độ khác nhau trong cùng một câu hoặc đoạn văn. Thay vì chỉ sử dụng một "đầu chú ý", Transformer sử dụng nhiều "đầu" hoạt động song song, giúp nắm bắt nhiều mối quan hệ ngữ nghĩa cùng lúc.

Mỗi đầu chú ý sẽ học một kiểu tương tác giữa các từ, từ đó tổng hợp lại thành thông tin toàn diện hơn. Cơ chế này đặc biệt hữu ích trong các tác vụ đòi hỏi phân tích ngữ cảnh phức tạp, như tìm kiếm thông tin trong văn bản, hiểu ý định người dùng, hoặc trích xuất thông tin chính xác từ tài liệu.

2.5. Mạng nơ-ron truyền thẳng (Feedforward Neural Network)

Sau khi xử lý thông tin bằng cơ chế chú ý, dữ liệu được đưa vào một mạng nơ-ron truyền thẳng để tiếp tục xử lý và học các biểu diễn phức tạp hơn. Mạng này thường bao gồm hai lớp tuyến tính (linear layers) với một hàm kích hoạt phi tuyến ở giữa, giúp mô hình học sâu hơn về cấu trúc và ý nghĩa của dữ liệu.

Feedforward Neural Network đóng vai trò quan trọng trong việc ra quyết định cuối cùng, như phân loại văn bản, tạo văn bản mới, hoặc đưa ra dự đoán hành vi người dùng. Trong môi trường doanh nghiệp, thành phần này có thể hỗ trợ trong việc dự báo nhu cầu khách hàng, phân tích xu hướng thị trường hoặc đề xuất sản phẩm.

2.6. Chuẩn hóa lớp và kết nối dư (Layer Normalization & Residual Connections)

Hai kỹ thuật này được tích hợp nhằm đảm bảo quá trình huấn luyện mô hình diễn ra ổn định và hiệu quả:

-

Layer Normalization giúp cân bằng dữ liệu đầu vào ở mỗi lớp, tránh các giá trị bất thường gây nhiễu trong quá trình học.

-

Residual Connections giúp giữ lại thông tin quan trọng từ các lớp trước đó bằng cách kết nối đầu vào ban đầu với đầu ra của mỗi lớp. Điều này giúp mô hình tránh bị mất thông tin trong quá trình lan truyền qua nhiều lớp.

Trong ứng dụng thực tế, những kỹ thuật này giúp mô hình hoạt động ổn định hơn khi xử lý khối lượng dữ liệu lớn, đặc biệt trong các bài toán như phân tích tài chính, đánh giá tín dụng, hoặc ra quyết định tự động trong doanh nghiệp.

2.7. Lớp đầu ra (Output Layer)

Lớp đầu ra là nơi tổng hợp toàn bộ thông tin đã được xử lý qua nhiều lớp trước đó và tạo ra kết quả cuối cùng của mô hình. Tùy theo nhiệm vụ cụ thể, lớp này có thể là một lớp softmax để phân loại, một lớp sinh văn bản, hoặc một lớp hồi quy để dự báo giá trị số.

Trong môi trường doanh nghiệp, lớp đầu ra có thể được sử dụng để sinh ra nội dung marketing, tự động hóa trả lời email, phân loại hồ sơ khách hàng, hoặc tạo báo cáo phân tích dựa trên dữ liệu văn bản đầu vào. Đây là bước giúp AI trở thành một công cụ ra quyết định thực thụ, hỗ trợ tối đa cho các phòng ban như marketing, chăm sóc khách hàng, vận hành hoặc tài chính.

3. Những biến thể nổi bật của Transformer Model

Từ kiến trúc nền tảng Transformer, nhiều mô hình chuyên biệt đã được phát triển để giải quyết các bài toán cụ thể trong xử lý ngôn ngữ tự nhiên. Các biến thể này không chỉ giúp tối ưu hóa hiệu suất cho từng tác vụ, mà còn mở rộng khả năng ứng dụng của AI vào nhiều lĩnh vực như tạo nội dung, tìm kiếm, dịch máy, phân tích văn bản và hơn thế nữa. Dưới đây là ba biến thể nổi bật và phổ biến nhất hiện nay:

3.1. GPT (Generative Pre-trained Transformer)

GPT là mô hình do OpenAI phát triển, nổi bật với khả năng sinh ngôn ngữ tự nhiên mạch lạc từ bất kỳ đoạn văn bản đầu vào nào. GPT hoạt động theo hướng unidirectional (một chiều), dự đoán từ tiếp theo dựa trên các từ đứng trước.

Ứng dụng điển hình:

-

Viết nội dung blog, mô tả sản phẩm, email marketing tự động.

-

Trò chuyện với khách hàng qua chatbot nâng cao.

-

Trợ lý ảo trả lời câu hỏi hoặc soạn thảo văn bản chuyên nghiệp.

Biến thể tiêu biểu: GPT-2, GPT-3, GPT-4 và mới nhất là GPT-4o giúp hỗ trợ đa phương thức và khả năng tương tác thời gian thực.

3.2. T5 (Text-to-Text Transfer Transformer)

T5 do Google phát triển, với cách tiếp cận độc đáo: chuyển mọi bài toán NLP về dạng “văn bản sang văn bản” (Text-to-Text). Từ phân loại, dịch máy đến tóm tắt hay trả lời câu hỏi,... tất cả đều xử lý dưới dạng đầu vào là câu hỏi và đầu ra là câu trả lời.

Ưu điểm nổi bật:

-

Dễ tích hợp vào nhiều tác vụ NLP khác nhau chỉ bằng cách thay đổi dữ liệu huấn luyện.

-

Khả năng tổng quát hóa cao, thích hợp cho doanh nghiệp cần AI "đa nhiệm".

Ứng dụng thực tế:

-

Viết lại tiêu đề, meta description để tối ưu SEO.

-

Trích xuất thông tin từ tài liệu theo định dạng có sẵn.

-

Hỗ trợ hệ thống hỏi đáp trong nội bộ doanh nghiệp.

3.3. BERT (Bidirectional Encoder Representations from Transformers)

BERT cũng được phát triển bởi Google, là mô hình đầu tiên sử dụng cơ chế học hai chiều (bidirectional) để hiểu ngữ cảnh toàn diện của một từ dựa trên các từ xung quanh, thay vì chỉ theo một chiều như GPT.

Ứng dụng nổi bật:

-

Hiểu ý định tìm kiếm của người dùng trong SEO và marketing.

-

Phân loại văn bản, phân tích cảm xúc, gợi ý nội dung phù hợp.

-

Tăng cường độ chính xác cho chatbot và hệ thống tìm kiếm nội bộ.

Biến thể phổ biến: RoBERTa, DistilBERT, ALBERT,... những phiên bản tối ưu hóa cho doanh nghiệp có nhu cầu triển khai nhanh và nhẹ hơn.

4. Sự khác biệt giữa Transformer và các mạng nơ-ron khác

Mỗi kiến trúc mạng nơ-ron sâu đều có ưu điểm riêng, nhưng Transformer đã nhanh chóng vươn lên trở thành chuẩn mới trong xử lý ngôn ngữ tự nhiên nhờ khả năng hiểu ngữ cảnh sâu, tốc độ xử lý nhanh và dễ mở rộng quy mô. Để hiểu rõ lý do vì sao Transformer được ứng dụng rộng rãi trong các mô hình AI hiện đại, dưới đây là bảng so sánh chi tiết giữa Transformer và các mạng nơ-ron phổ biến khác như RNN và CNN:

|

Tiêu chí |

Transformer |

RNN / LSTM / GRU |

CNN |

|

Cơ chế xử lý dữ liệu |

Xử lý song song toàn chuỗi với cơ chế self-attention |

Xử lý tuần tự, từng phần tử một |

Xử lý theo cửa sổ trượt, tốt cho dữ liệu hình ảnh |

|

Hiểu ngữ cảnh dài hạn |

Rất tốt nhờ attention |

Hạn chế do bị quên thông tin trước đó nếu chuỗi dài |

Kém hiệu quả với dữ liệu tuần tự dài |

|

Tốc độ huấn luyện |

Nhanh, dễ mở rộng trên GPU |

Chậm do tính tuần tự trong xử lý |

Nhanh nhưng thường dùng cho ảnh hơn là văn bản |

|

Khả năng song song hóa |

Cao – có thể huấn luyện toàn chuỗi cùng lúc |

Thấp – phải xử lý từng bước theo thứ tự |

Cao |

|

Cơ chế tập trung (attention) |

Có – sử dụng multi-head attention để hiểu nhiều khía cạnh dữ liệu |

Có (trong LSTM Attention) nhưng không mạnh như Transformer |

Không có |

|

Hiệu quả với dữ liệu chuỗi (ngôn ngữ) |

Rất cao – hiện là kiến trúc thống trị trong NLP |

Khá tốt – từng là tiêu chuẩn trước Transformer |

Hạn chế trong NLP, chủ yếu dùng cho nhận diện ảnh |

|

Tính mở rộng mô hình |

Cao – có thể mở rộng với số lớp lớn, phục vụ mô hình rất lớn (LLMs) |

Trung bình – sâu hơn dễ gây mất ổn định |

Cao nhưng ít dùng trong xử lý ngôn ngữ |

|

Ứng dụng điển hình |

ChatGPT, Google Translate, BERT, GPT, T5, DALL·E |

Dịch máy, phân tích chuỗi thời gian, chatbot truyền thống |

Nhận diện hình ảnh, phân loại ảnh, phân đoạn ảnh |

|

Chi phí tính toán |

Cao – do attention cần nhiều phép nhân ma trận |

Thấp hơn Transformer |

Thấp hơn Transformer |

|

Khả năng hiểu mối quan hệ giữa từ |

Rất mạnh – phân tích mối quan hệ giữa mọi từ trong chuỗi |

Giới hạn theo thời gian và độ dài chuỗi |

Không phù hợp cho việc hiểu ngữ nghĩa theo ngữ cảnh văn bản |

5. Vai trò quan trọng của Transformer Model

Transformer không chỉ là một bước tiến trong công nghệ AI mà còn là nền tảng cho hầu hết các mô hình ngôn ngữ lớn hiện nay. Nhờ khả năng xử lý ngôn ngữ hiệu quả và thích ứng với nhiều loại dữ liệu đầu vào, Transformer đang đóng vai trò trung tâm trong quá trình chuyển đổi số của doanh nghiệp, đặc biệt ở các lĩnh vực như tự động hóa, cá nhân hóa trải nghiệm và ra quyết định dựa trên dữ liệu.

-

Tăng khả năng hiểu ngữ cảnh và ngôn ngữ tự nhiên: Transformer cho phép AI nắm bắt mối quan hệ giữa các từ trong câu một cách chính xác, giúp hiểu sâu sắc ý định người dùng. Điều này đặc biệt quan trọng trong các ứng dụng như chatbot, phân tích phản hồi khách hàng hoặc hệ thống tìm kiếm thông minh.

-

Xử lý dữ liệu hiệu quả và song song hóa: Khả năng xử lý đồng thời toàn bộ chuỗi đầu vào giúp Transformer tiết kiệm thời gian huấn luyện và tăng hiệu suất khi triển khai thực tế. Đây là điểm mạnh vượt trội so với các mô hình truyền thống như RNN.

-

Thích ứng linh hoạt với nhiều loại dữ liệu: Ngoài văn bản, Transformer còn có thể ứng dụng cho hình ảnh, âm thanh và video thông qua các biến thể như Vision Transformer, Whisper hoặc các mô hình đa phương thức. Điều này mở rộng phạm vi sử dụng cho doanh nghiệp ở nhiều ngành nghề khác nhau.

-

Cải thiện chất lượng dự đoán và ra quyết định: Nhờ kiến trúc sâu và khả năng học từ dữ liệu lớn, Transformer cho kết quả chính xác hơn trong các tác vụ như phân loại, dự báo hành vi khách hàng hoặc đánh giá rủi ro tài chính. Điều này hỗ trợ các nhà quản lý đưa ra quyết định dựa trên dữ liệu một cách nhanh chóng và tin cậy.

-

Làm nền tảng cho các mô hình AI hiện đại: Các mô hình như GPT, BERT, T5, Claude hay Gemini đều được xây dựng dựa trên Transformer, chứng minh tính linh hoạt và khả năng mở rộng cao của kiến trúc này. Transformer đang dẫn đầu xu hướng AI hiện đại và là yếu tố cốt lõi trong nhiều giải pháp doanh nghiệp.

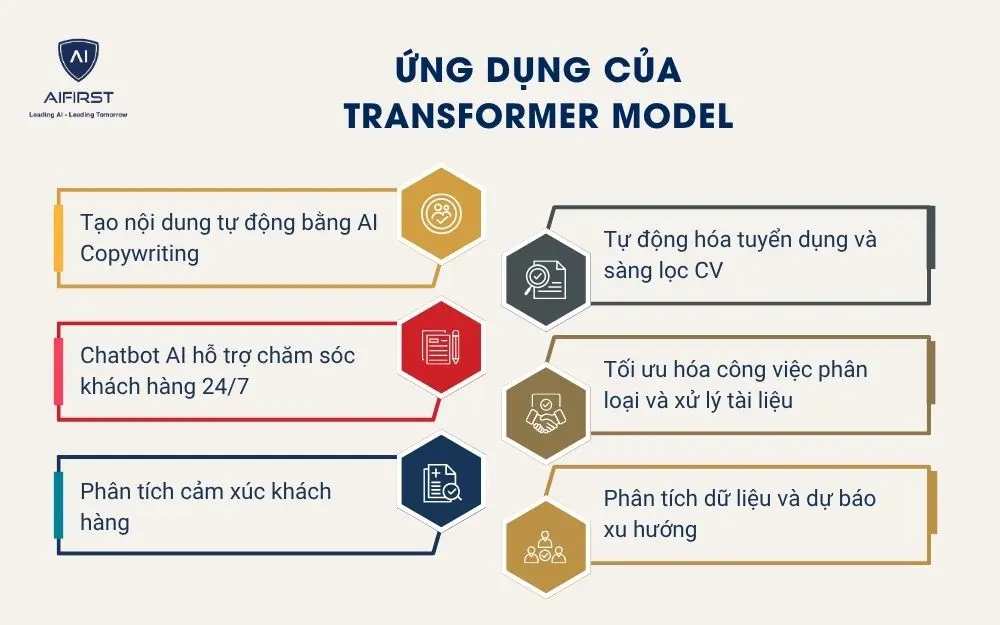

6. Ứng dụng của Transformer Model trong doanh nghiệp

Transformer Model không chỉ là một đột phá trong công nghệ xử lý ngôn ngữ, mà còn mang lại giá trị thực tiễn cho các doanh nghiệp vừa và nhỏ trong quá trình chuyển đổi số. Từ việc tự động hóa quy trình đến cá nhân hóa trải nghiệm khách hàng, Transformer đang dần trở thành công cụ chiến lược giúp tối ưu hiệu suất, tiết kiệm chi phí và nâng cao năng lực cạnh tranh.

6.1. Tạo nội dung tự động bằng AI Copywriting

Transformer Model giúp doanh nghiệp sản xuất nội dung nhanh chóng, chất lượng và nhất quán, đặc biệt trong hoạt động tiếp thị và bán hàng.

-

Tạo bài blog, mô tả sản phẩm, email marketing hoàn toàn tự động.

-

Đảm bảo nội dung đúng giọng thương hiệu và chuẩn SEO.

-

Rút ngắn thời gian ra mắt sản phẩm hoặc chiến dịch.

6.2. Chatbot AI hỗ trợ chăm sóc khách hàng 24/7

Transformer đóng vai trò cốt lõi trong các AI chatbot thông minh, giúp tương tác với khách hàng tự nhiên, chính xác và liên tục.

-

Trả lời câu hỏi, hỗ trợ tư vấn và đặt lịch hẹn tự động.

-

Tiết kiệm chi phí vận hành, giảm tải cho đội ngũ CSKH.

-

Cải thiện trải nghiệm khách hàng, nâng cao mức độ hài lòng.

6.3. Phân tích cảm xúc khách hàng

Nhờ khả năng hiểu ngữ nghĩa sâu, Transformer Model giúp phân tích hàng loạt phản hồi để đo lường cảm xúc khách hàng một cách chính xác.

-

Phát hiện nhanh các vấn đề tiêu cực đang lặp lại trong đánh giá.

-

Cung cấp insight để cải thiện sản phẩm, dịch vụ hoặc quy trình.

-

Theo dõi mức độ hài lòng của khách hàng theo thời gian thực.

6.4. Tự động hóa tuyển dụng và sàng lọc CV

Ứng dụng Transformer trong HR giúp doanh nghiệp tinh gọn quy trình tuyển dụng, đặc biệt trong giai đoạn sàng lọc hồ sơ ban đầu.

-

Trích xuất và phân tích thông tin từ hàng trăm CV nhanh chóng.

-

So khớp hồ sơ với yêu cầu công việc một cách chính xác.

-

Tự động hóa phản hồi email và lên lịch phỏng vấn.

6.5. Tối ưu hóa công việc phân loại và xử lý tài liệu

Transformer Model có thể đọc, hiểu và phân loại tài liệu một cách chính xác, giảm gánh nặng cho các bộ phận vận hành, pháp lý, kế toán.

-

Tự động phân loại hợp đồng, hóa đơn, email theo nội dung.

-

Trích xuất thông tin quan trọng như ngày ký, số tiền, tên đối tác.

-

Giảm sai sót và tiết kiệm thời gian nhập liệu thủ công.

6.6. Phân tích dữ liệu và dự báo xu hướng

Bên cạnh xử lý ngôn ngữ, Transformer còn được ứng dụng để phân tích dữ liệu và dự đoán hành vi trong thời gian thực.

-

Dự báo nhu cầu khách hàng, xu hướng mua hàng, biến động thị trường.

-

Hỗ trợ xây dựng báo cáo và mô hình ra quyết định dựa trên dữ liệu.

-

Tăng khả năng phản ứng nhanh của doanh nghiệp trong môi trường cạnh tranh.

7. Xu hướng của Transformer Model trong tương lai

Cùng với sự phát triển nhanh chóng của công nghệ AI, Transformer Model không ngừng được cải tiến để phù hợp hơn với nhu cầu thực tế của doanh nghiệp và xã hội. Các xu hướng dưới đây đang định hình tương lai của Transformer, mở ra cơ hội mới cho doanh nghiệp trong việc ứng dụng AI hiệu quả hơn, chi phí thấp hơn và dễ triển khai hơn.

7.1. Mô hình Transformer nhỏ gọn nhưng mạnh mẽ hơn

Một trong những thách thức lớn nhất của Transformer là chi phí tính toán và tài nguyên phần cứng. Vì vậy, xu hướng hiện nay là phát triển các mô hình nhẹ hơn nhưng vẫn đảm bảo độ chính xác cao, phù hợp cho doanh nghiệp nhỏ và vừa.

-

Các mô hình như DistilBERT, MobileBERT, TinyGPT… giúp giảm 40–60% số lượng tham số mà vẫn giữ hiệu suất gần tương đương với bản đầy đủ.

-

Phù hợp để triển khai trên thiết bị có cấu hình thấp, hoặc tích hợp vào hệ thống nội bộ mà không cần GPU mạnh.

Doanh nghiệp có thể dùng các mô hình này để xử lý văn bản nội bộ, xây chatbot hoặc tự động hóa văn phòng mà không cần đầu tư hạ tầng đắt đỏ.

7.2. Mô hình Transformer đa phương thức (Multimodal Transformer)

Transformer đang được mở rộng từ xử lý văn bản sang xử lý đồng thời nhiều loại dữ liệu như hình ảnh, âm thanh, video, cảm biến IoT… để tạo ra các mô hình thông minh toàn diện hơn.

-

Mô hình như GPT-4o, Gemini, Claude 3 có khả năng đọc hình ảnh, hiểu giọng nói, và tạo nội dung đa dạng.

-

Tích hợp đầu vào và đầu ra dạng văn bản, hình ảnh, file âm thanh hoặc dữ liệu cảm biến.

Ví dụ: Một trung tâm thẩm mỹ có thể dùng công nghệ phân tích da bằng AI, nhận diện loại da và đề xuất liệu trình điều trị phù hợp,... tất cả trong một hệ thống AI duy nhất.

7.3. Ứng dụng Transformer Model trong tự động hóa doanh nghiệp

Transformer đang đóng vai trò ngày càng lớn trong việc xây dựng hệ thống tự động hóa thông minh, không chỉ dừng lại ở phân tích mà còn có thể hành động và phối hợp giữa các tác vụ phức tạp.

-

Tích hợp vào các AI Agent Platform, hệ thống có thể lập kế hoạch, ra quyết định và tự động xử lý công việc.

-

Tự động gửi email, tạo báo cáo, phân tích dữ liệu, hoặc quản lý thông tin khách hàng từ nhiều nguồn.

Doanh nghiệp thương mại có thể dùng AI để giám sát phản hồi khách hàng, tự động phân nhóm, gửi khảo sát và đề xuất hành động cải thiện mà không cần can thiệp thủ công.

7.4. Tích hợp Transformer vào phần mềm qua No-code/Low-code

Khi nhu cầu ứng dụng AI tăng cao, nhiều doanh nghiệp không có đội ngũ kỹ thuật chuyên sâu đang chuyển hướng sang các nền tảng No-code hoặc Low-code để tích hợp AI nhanh chóng và tiết kiệm chi phí.

-

Các nền tảng như Zapier AI, Chatbase, Retune, Flowise, LangChain… cho phép kéo thả để xây dựng hệ thống AI.

-

Không cần lập trình vẫn có thể kết nối Transformer với hệ thống CRM, email marketing, quản lý khách hàng,…

Ví dụ: Một công ty giáo dục có thể dùng ChatGPT 4.0 kết hợp với Chatbase để xây dựng chatbot tư vấn khóa học, hoạt động 24/7 trên website mà không cần đội kỹ thuật.

Transformer Model không chỉ là công nghệ cốt lõi của các hệ thống AI hiện đại, mà còn là chìa khóa giúp doanh nghiệp tối ưu vận hành và tăng trưởng thông minh. Nếu bạn đang tìm kiếm giải pháp ứng dụng AI vào thực tế, đừng bỏ lỡ các bài viết chuyên sâu từ AI FIRST. Theo dõi ngay hôm nay để cập nhật xu hướng và kiến thức mới nhất về Transformer Model và công nghệ AI.